CVPR2024:威尼斯官网张永军老师团队的双目视觉算法在全球权威的KITTI榜单排名第一

发布时间: 2024-03-20 | 查看数:1703

近日,威尼斯官网金沙威尼斯欢乐娱人城张永军老师团队在IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2024 (计算机学会推荐CCF A 类、人工智能领域国际顶级会议)上发表题为“MoCha-Stereo: Motif Channel Attention Network for Stereo Matching”的研究论文。这是金沙威尼斯欢乐娱人城独立完成并作为唯一通讯单位被CVPR录用论文,第一作者为我院2022级研究生陈子扬同学,通讯作者为张永军老师。

CVPR是全球人工智能和计算机视觉领域顶级国际会议,有着计算机视觉领域“奥斯卡”的美誉。在谷歌学术Google Scholar指标2021年至2023年列出的全球最有影响力的科学期刊/会议中,CVPR均位列第四,仅次于《自然》《新英格兰医学杂 志》《科学》。

双目视觉立体匹配算法是智能机器人、自动驾驶、无人机导航,以及智慧机器人导航等产业AI应用的关键算法,对于计算机视觉领域和三维立体感知等AI技术,具有十分重要的意义。本文提出捕获特征通道中重复出现的几何结构以修正立体匹配代价计算的方法,简称MoCha-Stereo。从2023年5月起,MoCha-Stereo在全球双目视觉算法权威榜单KITTI排名第一。实验表明,该算法超过了谷歌HITNet、普林斯顿RAFT-Stereo、牛津大学GANet、欧洲NAVER人工智能实验室CroCo-Stereo、东京大学LocalExp等算法的性能。

算法实时排名如下图所示(截至2024年1月20日):

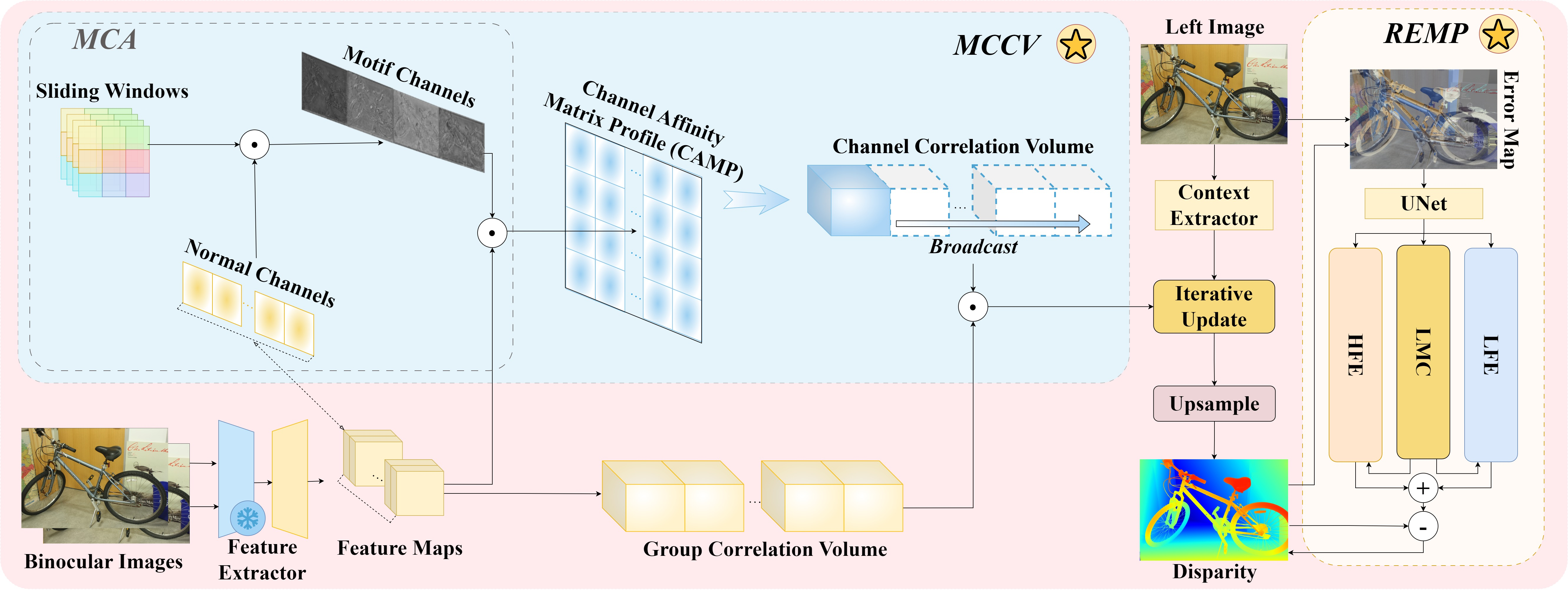

在双目立体匹配领域,CroCo-Stereo和GANet等基于深度学习的立体匹配技术已经取得了重大进展。然而,现有方法在生成特征通道的过程中不可避免地会丢失几何结构信息,导致边缘细节不匹配。本文提出Motif Channel Correlation Volume,通过将捕捉特征通道中重复出现的模式,并将这种模式重新投影到特征图和成本体积上,实现更精确的双目图像边缘细节的匹配代价计算。为了进一步细化几何纹理的匹配,本文提出REMP模块,结合重建误差和高低频特征中重复出现的模式,惩罚全分辨率视差的错误计算。以上范式构成了MoCha-Stereo网络,这种网络以投影的方式修复了特征通道中丢失的细节特征,实现了更精细的匹配效果。

本文主要工作如下:

一、设计了一个新颖的立体匹配网络以关注特征通道中重复出现的几何轮廓。这种网络架构通过对特征通道的细节还原,实现更精确的立体匹配代价计算和视差估计。

二、提出了Motif Channel Attention来缓解深度学习训练中不平衡的非线性变换。这种注意力使用滑动窗口获取重复特征,通过投影这种重复特征的方式修复特征通道的纹理结构。

三、构建了Channel Affinity Matrix Profile引导匹配代价体的计算。该矩阵计算了普通通道和重复特征之间的相关性,这种相关关系的映射使得网络可以计算一个更合理的匹配代价。

四、开发了REMP从重建误差图和视差图的高低频信号中挖掘重复模式以惩罚视差的计算。这种新的视差优化方式可以充分利用重建误差图的几何信息以修正细节的匹配。

MoCha-Stereo网络结构图如下:

一审:唐玮欣

二审:何 飞

三审:龙慧云